wordpress网站安装插件,南京小程序建设公司,wordpress 显示错误500,网站 302重定向 备案XTuner 大模型单卡低成本微调实战 Finetune简介

常见的两种微调策略#xff1a;增量预训练、指令跟随

指令跟随微调

数据是一问一答的形式 对话模板构建 每个开源模型使用的对话模板都不相同

指令微调原理#xff1a; 由于只有答案部分是我们期望模型来进行回答的内容…XTuner 大模型单卡低成本微调实战 Finetune简介

常见的两种微调策略增量预训练、指令跟随

指令跟随微调

数据是一问一答的形式 对话模板构建 每个开源模型使用的对话模板都不相同

指令微调原理 由于只有答案部分是我们期望模型来进行回答的内容所以我们只对答案部分进行损失的计算

增量预训练微调

数据都是陈述句没有问答形式

LoRA QLoRA

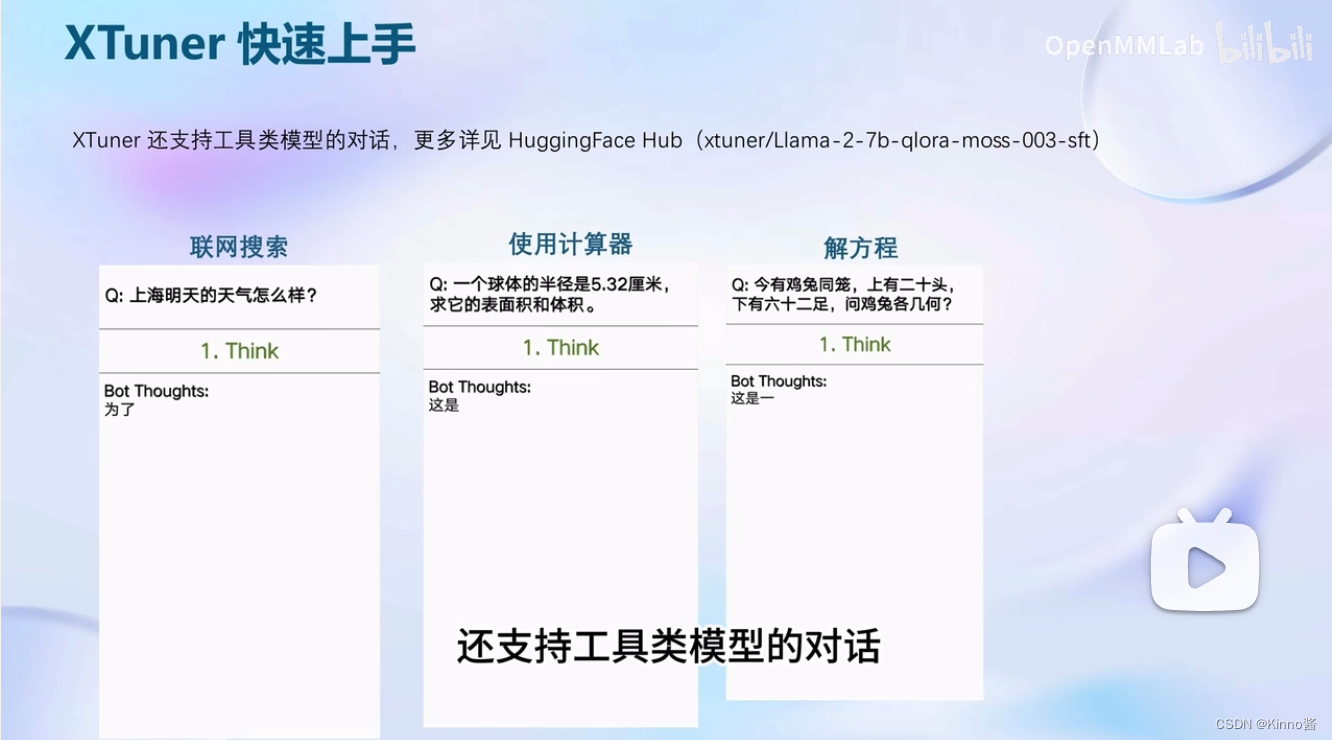

XTuner中使用的微调原理LoRA QLoRA 如果我们要对整个模型的所有参数都进行调整的话需要非常大的显存才能够进行训练但是用LoRA的方法就不需要这么大的显存开销了 比较全参数微调、LoRA、QLoRA 全参数微调整个模型都要加载到显存中所有模型参数的优化器也都要加载到显存中显存不够根本无法进行· LoRA模型也是要先加载到显存中但是我们只需要保存LoRA部分的参数优化器大大减小了显存占用 QLoRA加载模型时就使用4bit量化的方式加载相当于不那么精确的加载但是可以节省显存开销QLoRA部分的参数优化器还可以在GPU和CPU之间进行调度【这是Xtunner进行整合的功能 】显存满了就自动去内存中去跑。 XTuner介绍 XTuner快速上手

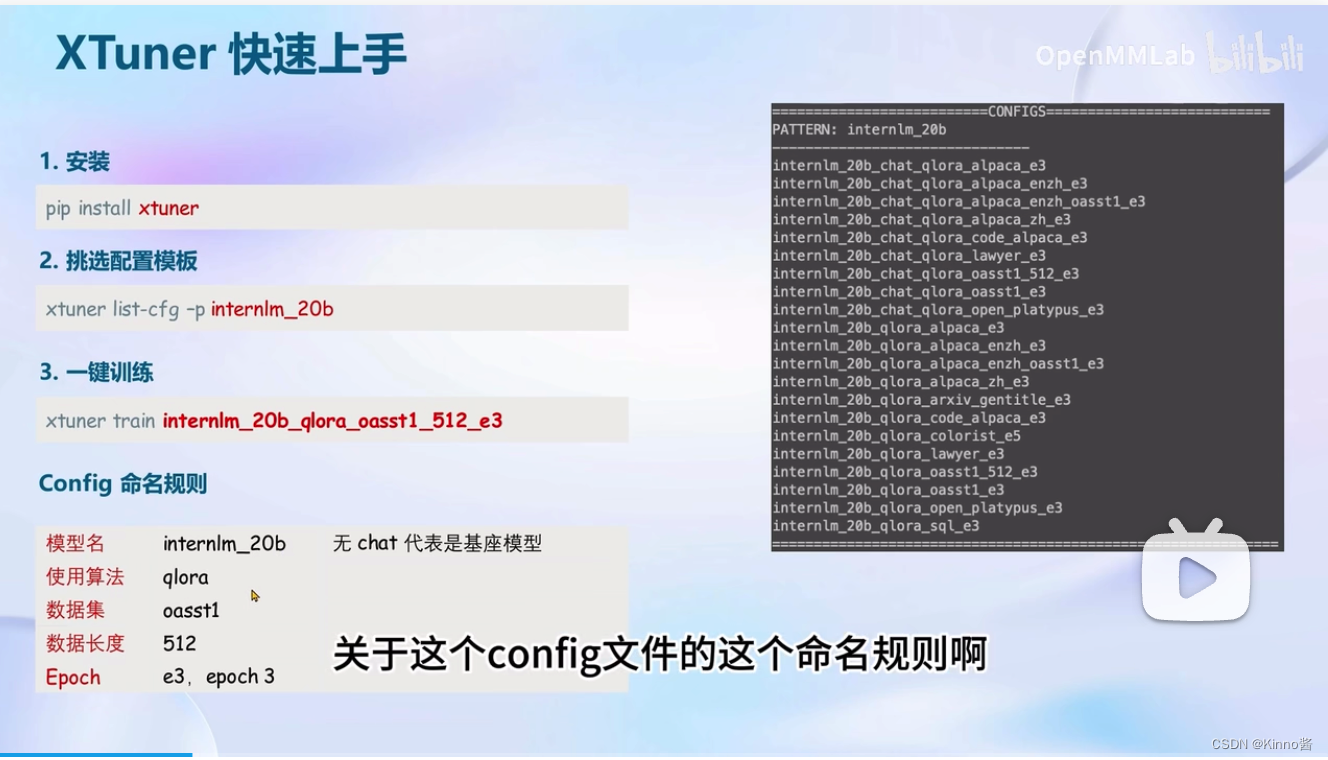

安装

pip install xtuner挑选配置模版

xtuner list-cfg -p internlm_20b一键训练

xtuner train internlm_20b_qlora_oasst1_512_e3Config 命名规则

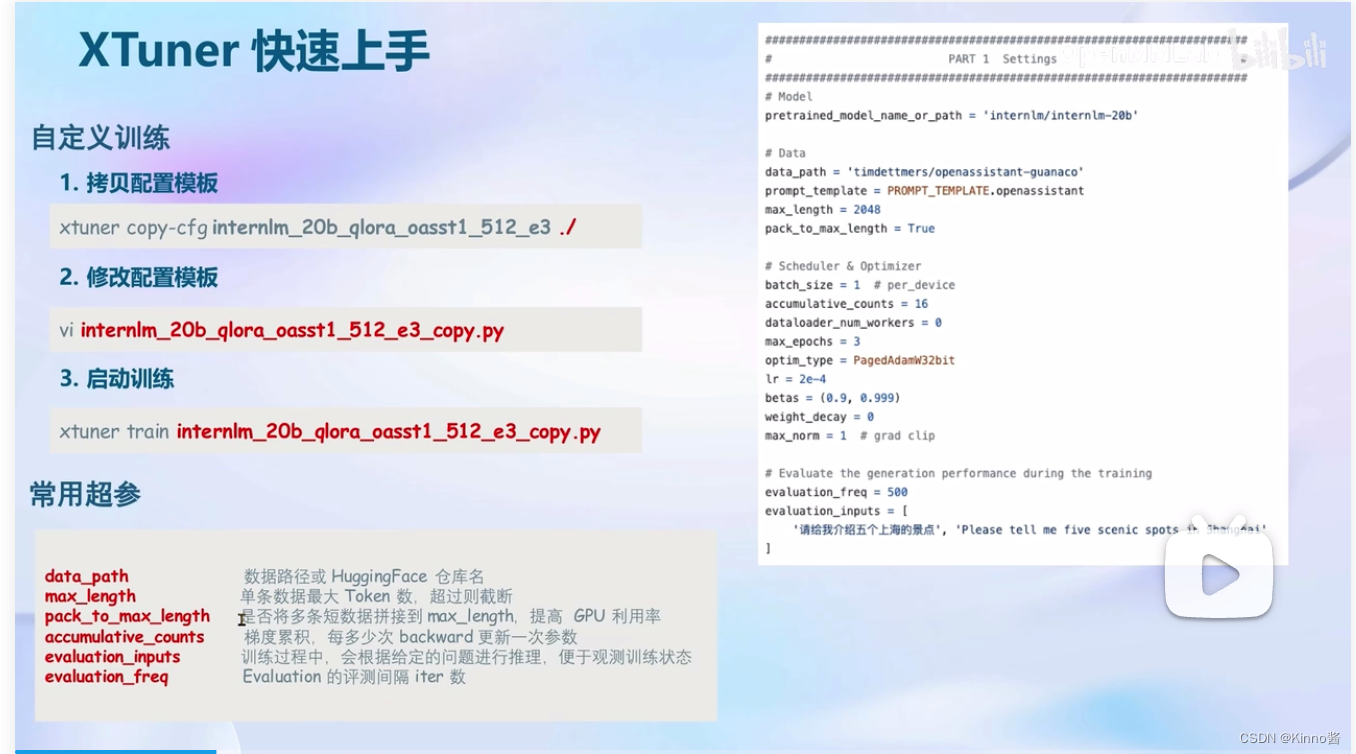

模型名internlm_20b ( 无 chat 代表是基座模型 )使用算法qlora数据集oasst1数据长度512Epoche3, epoch 3     XTunner支持多数据的样本拼接增加运行效率输入模型统一的进行梯度的传播 自定义数据集建议使用json格式

8GB显卡玩转LLM 动手实战环节

https://github.com/InternLM/tutorial/blob/main/xtuner/README.md